如何正确解析网站写入Robots.txt文件?解析后常见问题有哪些?

![]() 游客

2025-05-03 13:34:01

21

游客

2025-05-03 13:34:01

21

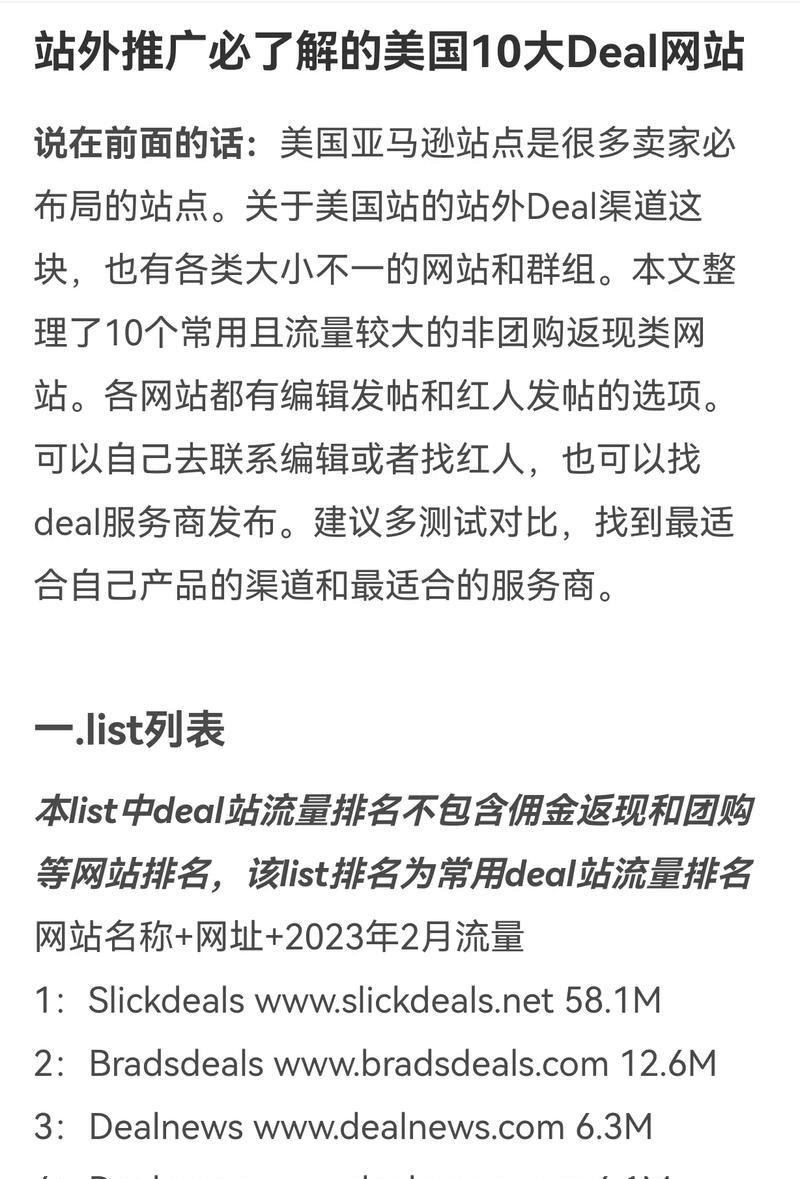

在搜索引擎优化(SEO)的世界中,Robots.txt文件是控制搜索引擎爬虫行为的重要工具。它就像一扇门,决定了搜索引擎能否访问网站中的某些页面。正确配置Robots.txt不仅可以提高SEO效率,还能保护网站内容的安全。本文将带您全面解析如何正确写入Robots.txt,确保您的网站对搜索引擎友好且高效。

什么是Robots.txt?

Robots.txt是一个位于网站根目录下的纯文本文件,它告诉搜索引擎爬虫哪些页面可以抓取,哪些不可以。它是网站与搜索引擎之间的一个非强制性协议,但大多数搜索引擎爬虫会遵循它的指示。

为什么要正确写入Robots.txt?

正确设置Robots.txt能够:

阻止搜索引擎抓取不必要的页面,比如重复内容、付费会员区,或者不希望出现在搜索结果中的内容;

避免抓取资源的浪费,比如图片、视频等非文本内容;

提高网站抓取效率,因为搜索引擎爬虫会根据Robots.txt来优化抓取策略;

防止敏感信息被索引,保护网站和用户数据安全。

如何写入Robots.txt?

Step1:了解基本格式

Robots.txt文件的基本格式包括两部分:User-agent和Disallow/Allow指令。

Useragent:指的是爬虫的名称,如果指令是针对所有爬虫的,则使用星号(*)代表;

Disallow:告诉爬虫哪些URL不可以抓取;

Allow:与Disallow相对,指明哪些URL可以抓取;

:注释符号,后文跟随的文本将被忽略。

Step2:打开或创建Robots.txt文件

通常,您可以在网站根目录下创建或修改Robots.txt文件。如果您使用的是WordPress等CMS,可以通过安装专门的插件来更简便地管理。

Step3:编写基本规则

下面是一个基本的Robots.txt文件示例:

```

User-agent:*

Disallow:/cgi-bin/

Disallow:/tmp/

Disallow:/~username/

Allow:/search/

```

以上示例表示:所有爬虫都不能访问/cgi-bin/、/tmp/和/~username/目录,但可以抓取/search/目录下的内容。

Step4:特殊指令与注意事项

Sitemap:您可以在此处指定网站的XML地图位置,方便爬虫查找并索引网站内容。

Crawldelay:这个指令可以设定爬虫两次请求之间等待的时间,有助于避免服务器过度负载。

文件大小和编码:确保Robots.txt文件体积不要太大,且使用UTF8或ASCII编码。

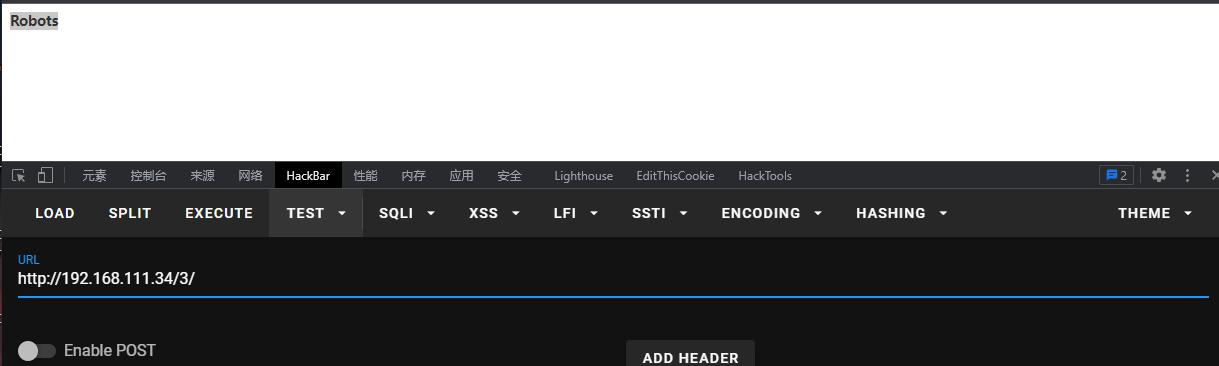

Step5:测试Robots.txt配置

配置完成后,您应使用[Robots.txt测试工具](https://www.baidu.com/s?wd=Robots.txt%20%E6%B5%8B%E8%AF%95%E5%B7%A5%E5%85%B7)检查是否按照预期设置。不同的搜索引擎提供各自的Robots.txt测试工具。

常见问题解答

问题1:Robots.txt可以完全阻止内容被搜索引擎索引吗?

答案是不可以。虽然Robots.txt可以阻止大多数爬虫,但是它并不是一个安全措施。如果内容很重要,请使用更安全的方法(如HTTP基本认证)来保护。

问题2:如果写入错误的规则会怎样?

如果写入了错误的规则,可能会导致搜索引擎无法索引本应公开的页面,或者搜索引擎爬虫频繁访问禁止的页面,从而影响网站性能。

问题3:Robots.txt需要多久更新一次?

Robots.txt的更新频率取决于网站内容的变化。如果网站结构经常变动或添加了新的内容区域,您可能需要定期检查和更新Robots.txt文件。

综上所述

写入Robots.txt是提升网站SEO表现的一个关键步骤。通过合理配置,您可以更精准地控制搜索引擎爬虫的访问权限,优化网站索引情况,避免不必要的资源浪费,并且保护敏感数据不被公开。遵循本文的步骤和建议,您可以轻松地掌握Robots.txt的使用技巧,进一步提升网站的整体性能和用户体验。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

转载请注明来自九九seo,本文标题:《如何正确解析网站写入Robots.txt文件?解析后常见问题有哪些?》

标签:

- 搜索

- 最新文章

- 热门文章

-

- 营销网站怎么推广产品?如何有效提升产品在线销售?

- 如何推广演讲题材网站?有效策略和常见问题解答?

- 抖音卖车图片和视频剪辑技巧有哪些?

- 短视频优化软件怎么下载?下载过程中常见问题有哪些?

- 改版网站降权了怎么办?如何快速恢复网站权重?

- 如何免费推广营销网站?推广网站有哪些有效方法?

- 小红书作品剪辑怎么弄的?视频编辑的步骤和技巧是什么?

- 怎么查网站核心关键词?有效方法有哪些?

- 小红书视频剪辑时如何添加边框?常见问题解答?

- HTML标记的英文名称有哪些?如何正确使用它们?

- 食堂网站如何推广的?有哪些有效策略?

- 短视频优化数据节点怎么做?如何通过数据节点提升短视频表现?

- 抖音点唱剪辑如何制作?怎样才能让点唱视频更吸引人?

- 剪辑博主小红书怎么做?如何打造受欢迎的视频内容?

- 分析论文网站推荐怎么写?如何选择合适的论文分析平台?

- 网站招聘如何精准推广?有效提升招聘效果的策略是什么?

- 抖音栏杆断裂视频剪辑方法是什么?剪辑时应注意哪些问题?

- 快手出品音乐片段剪辑方法是什么?遇到问题如何解决?

- 如何做个网站推广代理?需要哪些步骤和技巧?

- HTML教材有哪些?如何选择适合自己的学习材料?

- 热门tag

- 标签列表