如何关闭搜索引擎功能文件夹?操作步骤是什么?

![]() 游客

2025-05-10 10:34:01

25

游客

2025-05-10 10:34:01

25

在互联网信息高度发达的今天,搜索引擎成为了我们获取信息的重要途径。然而,在某些情况下,网站管理员可能出于隐私保护或安全考虑,需要关闭搜索引擎的功能文件夹。本文将为您提供操作步骤及注意事项,确保您的网站安全和隐私得到保障。

关键点一:为什么要关闭搜索引擎的功能文件夹?

在开始操作之前,理解关闭搜索引擎功能文件夹的重要性是十分必要的。一般来说,搜索引擎爬虫在索引网站内容时,可能会访问一些网站管理员不希望被公开索引的文件夹。比如,管理员区域、用户数据存储区域等,都可能包含敏感信息。关闭这些文件夹,可以避免潜在的数据泄露风险,同时也可以减少搜索引擎爬虫对服务器资源的不必要消耗。

关键点二:了解Robots.txt的作用

在详细介绍如何关闭功能文件夹之前,首先需要了解Robots.txt文件的作用。Robots.txt是一个放置在网站根目录下的纯文本文件,用于指导搜索引擎爬虫哪些页面可以抓取,哪些不可以。它为网站管理员提供了一种简便的控制搜索引擎爬虫访问网站内容的方式。

关键点三:操作步骤详解

步骤一:创建或编辑Robots.txt文件

1.使用文本编辑器创建一个名为“Robots.txt”的文件。

2.如果网站已存在Robots.txt文件,直接打开编辑。

3.将以下基础代码放入文件中:

```

User-agent:*

Disallow:/

```

这段代码的作用是禁止所有搜索引擎爬虫访问网站的任何内容。

步骤二:指定允许访问的文件夹

如果您只是想要关闭特定的功能文件夹,而不是整个网站,可以修改Robots.txt文件,使其包含以下

```

User-agent:*

Disallow:/特定功能文件夹/

```

请将`/特定功能文件夹/`替换为您希望阻止搜索引擎爬取的实际文件夹路径。

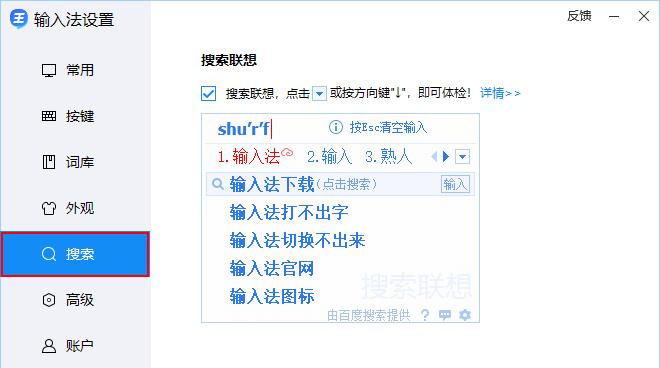

步骤三:测试Robots.txt是否有效

编辑完成之后,需要确保Robots.txt文件能被正常访问。可以通过浏览器输入“http://www.您的网站.com/Robots.txt”来查看内容是否正确。

为了确认设置是否有效,可以使用在线的Robots.txt检查工具进行验证。

步骤四:提交Robots.txt文件

将Robots.txt文件上传到您的网站根目录,并确保搜索引擎索引了最新的Robots.txt文件。您还可以主动将文件提交给各大搜索引擎,如通过GoogleSearchConsole提交。

关键点四:注意事项

1.正确设置路径:在设置Robots.txt文件时,一定要确保路径正确无误,否则可能会导致误阻止其他页面的爬取。

2.测试:在正式上线前,一定要对Robots.txt文件进行充分测试,确保其效果符合预期。

3.逐步撤销:如果需要再次开放被禁止访问的文件夹,只需修改或删除相应的“Disallow”指令即可,然后重新提交或测试Robots.txt文件。

关键点五:维护与更新

随着时间的推移,您的网站结构和内容可能发生变化,因此Robots.txt文件也需要定期维护和更新。同时,网站管理员应时刻关注搜索引擎更新的规则,以确保Robots.txt文件始终有效且安全。

综上所述,关闭搜索引擎功能文件夹需要简单的步骤,通过设置Robots.txt文件,您可以有效地控制搜索引擎对网站内容的抓取范围。务必遵循操作流程,同时注意对文件的定期检查和维护,以保证网站的隐私和安全。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

转载请注明来自九九seo,本文标题:《如何关闭搜索引擎功能文件夹?操作步骤是什么?》

标签:关闭

- 搜索

- 最新文章

- 热门文章

-

- 兼职网站推广如何收费?收费标准有哪些?

- 如何在推广自己的网站?有效策略和常见问题解答?

- 快手小女孩声音剪辑教程?剪辑时应注意哪些问题?

- 网站导航如何优化推广?提升用户体验的关键步骤是什么?

- 网站界面改版设计图怎么做?改版流程和注意事项是什么?

- 网站网址分析怎么写?分析网站网址的正确方法是什么?

- HTML眼睛语法有哪些?如何正确使用HTML眼睛语法?

- 视频网站盈收分析报告怎么写?需要关注哪些关键指标?

- 网站推广营销策略怎么写?如何制定有效的推广计划?

- 快手放映室剪辑视频怎么弄?操作步骤和常见问题解答?

- 营销网站视频制作教程?视频制作流程和常见问题解答?

- 舆情分析网站怎么做?如何打造有效的网络舆情监控平台?

- 网站架构侵权怎么解决?如何避免和处理网站架构侵权问题?

- 焦作短视频优化怎么做?如何提升短视频在搜索引擎中的排名?

- 快手翅膀花字怎么剪辑的?剪辑步骤和技巧是什么?

- 网站视觉改版怎么排版?改版后如何保持用户体验?

- 小游戏网站架构图怎么做?需要考虑哪些因素?

- 营销型网站怎么布局?布局策略和常见问题解答?

- 怎么分析网站统计数据?掌握这些技巧轻松提升SEO效果

- HTML学习内容有哪些?如何系统掌握HTML基础?

- 热门tag

- 标签列表